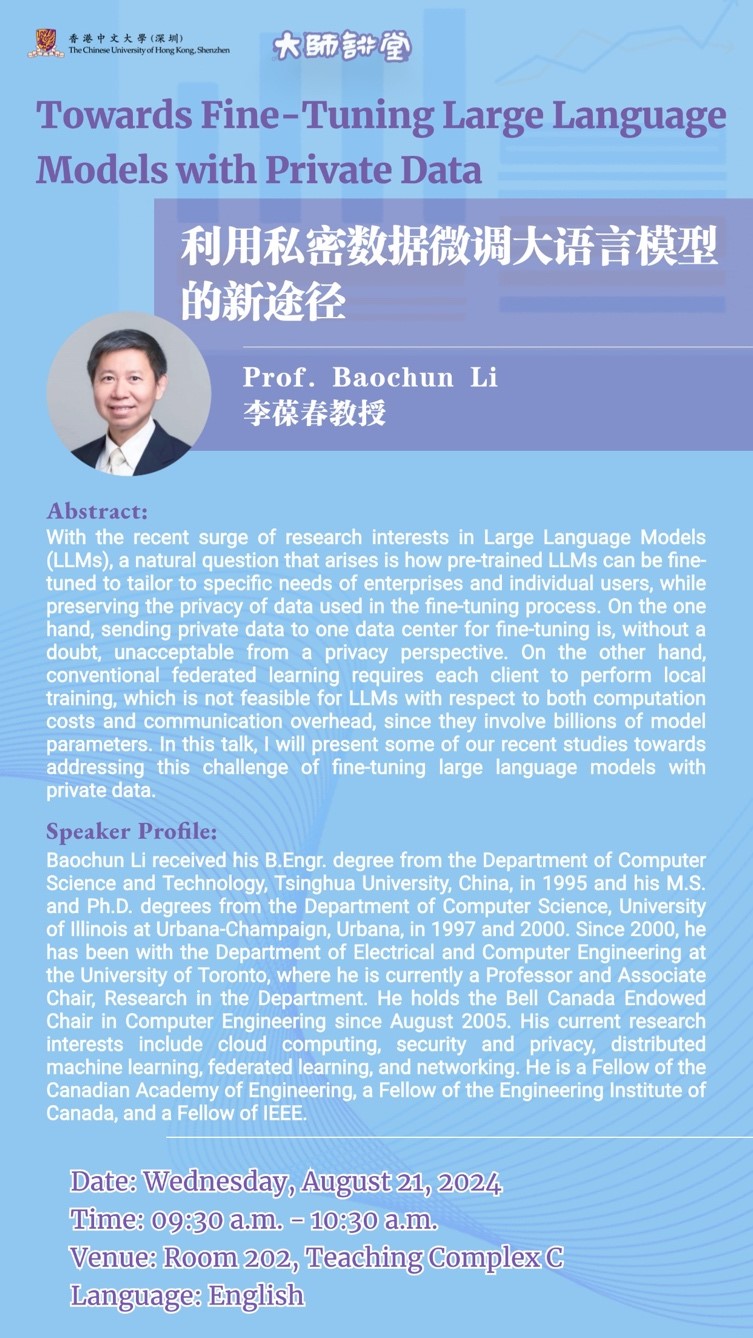

【大师讲堂】利用私密数据微调大语言模型的新途径

主题:利用私密数据微调大语言模型的新途径

主讲人:李葆春教授

日期:2024年8月21日(周三)

时间:上午9:30-10:30

地点:综合教学楼C栋202

语言:英文

摘要:

随着大语言模型(LLM)研究热潮的兴起,一个亟待解决的问题出现了:如何在保护数据隐私的前提下对大语言进行微调以满足企业和个人用户的特定需求。从隐私的角度来看,将私有数据上传至数据中心进行微调显然不合适。而传统的联邦学习方法则需要在每个客户端上进行本地训练,这对于包含数十亿参数的大语言模型来说,计算和通信开销过大,并不可行。

在本次讲座中,我将介绍我们团队在使用私有数据微调大语言模型方面的最新研究进展。首先,我将介绍Titanic,这是一种新型的分布式训练方法,它能够在保护隐私的同时直接在产生私密数据的客户端设备上安全地微调大语言模型,同时兼顾计算和通信带宽的资源限制。Titanic的核心理念是将大语言模型分割到多个客户端设备上,使得在微调过程中的性能损失为零或降至最低,达到最佳表现效果。在设计Titanic时,我们特别注重其在实际应用中的可行性,并开发了一套全自动的、适用于各种模型的分割机制。最后,我将简要介绍我们团队目前在做的一项研究——利用多个云平台在分布于不同地区的数据中心执行分布式机器学习。该方法在训练任务分配到全球各地的数据所在地,有效地保护了数据隐私。我们的愿景是构建一个覆盖各个数据中心的高速网络,可以多路径传输数据并在网络状态变化时快速作出优化响应。

主讲嘉宾简介:

李葆春教授于1995年在清华大学获得计算机科学与技术学士学位,随后分别于1997年和2000年在伊利诺伊大学厄巴纳—香槟分校计算机科学系获得硕士和博士学位。2000年,他加入多伦多大学电气与计算机工程系,现任该系教授兼科研副主任。2005年8月,李教授担任贝尔加拿大计算机工程教授。他的研究领域涵盖云计算、信息安全与隐私保护、分布式机器学习、联邦学习及网络技术。

根据Google Scholar的统计,李教授迄今已发表470余篇高水平研究论文,论文总引用次数超过26,000次,H指数高达88,i10指数为341。李教授现为加拿大工程院院士、加拿大工程学会会士及国际电气与电子工程师协会(IEEE)会士,曾荣获2000年IEEE通信学会Leonard G. Abraham奖、2009年IEEE通信学会多媒体通信最佳论文奖、2009年多伦多大学麦克莱恩奖、2023年IEEE INFOCOM最佳论文奖以及2024年IEEE INFOCOM成就奖。